Файл robots.txt для Joomla

Важным моментом при самостоятельном продвижении и раскрутке сайта является повышение показателя индексации сайта. Поскольку доминируют в рунете поисковые системы Яндекс и Google, поэтому стоит уделить особое внимание индексации сайта в Яндексе и Google. Так как от этого будет зависеть успешное продвижение сайта в целом комплексе этапа раскрутки.

При обходе поисковыми роботами сайтов с целью индексации, вначале происходит проверка файла robots.txt, и в зависимости от прописанных в нем правил, осуществляются дальнейшие действия поискового робота.

При отсутствии файла robots.txt для joomla, действия поискового робота к сайту могут быть самые разные: проиндексировать, частично проиндексировать или вообще проигнорировать. При наличии файла robots.txt, причем грамотно составленного, поисковый робот будет осуществлять целенаправленную индексацию сайта.

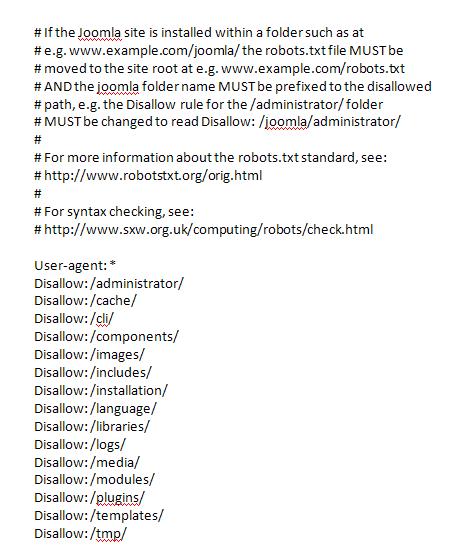

Вот так выглядит стандартный файл robots.txt в дистрибутиве Joomla 2.5, после установки сайта на сервер.

Данный файл robots.txt для joomla работоспособен, но в нем необходимо произвести изменения, которые существенно повысят эффективность индексации сайта поисковыми роботами.

Вот какие нужно произвести поправки для файла.

Правило Disallow: /images/ создает запрет на индексацию к папке для картинок на сайте. Закрытие папки images от индексирования означает отказ от участия в поиске по картинкам Яндекса и Google. Эту директиву необходимо удалить из файла robots.txt.

Для участия изображений в поиске по картинкам Яндекса и Google необходимо прописывать атрибуты Alt и Title. Так как эти атрибуты будут являться ключевыми словами для поиска по картинкам Яндекса и Google.

При работе в панели Яндекс – Вебмастер раздел “Исключенные страницы” выдается сообщение: HTTP-статус: Ресурс не найден (404) и показаны страницы намеренно запрещены к индексированию. Одной из причин такого сообщения является отсутствие правила указывающего путь к файлу Sitemap. Этот недочет должен быть восстановлен.

Как сделать карту сайта и файл Sitemap смотрите в статье: Карта сайта для Joomla 2.5

Так же обязательно следует добавить в файл robots.txt отдельное правило

User-agent: Yandex для вставки директивы Host, определяющей главное зеркало сайта для Яндекса (зеркало сайта – это URL сайта с www или без).

Для того, чтоб закрыть директорию категории, нужно создать следующее правило:

Пример:

Disallow: */10-kategoriya.html

‘*’ – звездочка означает любые символы, то есть все то, что стоит до слэша (позиция звездочки до слэша */ или после /* - это имеет большое значение)

‘10’ – это id категории

‘kategoriya’ – это алиас категории (принадлежащей id 10)

Каким правилом можно закрыть:

- страницы для печати

- индексацию новостных каналов

- PDF файлы

- динамические ссылки

- страницы поиска и другие страницы

пояснено в статье robots.txt Как устранить дубли для сайта Joomla 2.5

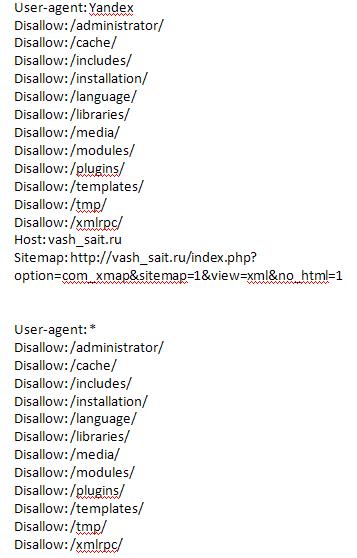

Для предпочтения поисковика Яндекс, необходимо User-agent: Yandex ставить в начале файла. В итоге файл robots.txt должен выглядеть так:

Данный пример не является эталоном, но его можно принять за основу.

После корректировки файла (вы также можете добавлять свои правила в robots.txt), проверка файла robots.txt для joomla обязательна. Так как в случае ошибки, истинные страницы могут быть закрыты для робота, и исчезнут из поиска.

Для удобства проверки страниц сайта на работоспособность, нужно создать текстовый документ и в него скопировать со своей страницы “Карта сайта” все существующие url-адреса, в удобочитаемом виде (каждый url-адрес с новой стрки).

Другой вариант составления списка url-адресов:

В Панели управления: открыть Компоненты ->Xmap -> нажать на ссылку XML Sitemap. Откроется окно карта сайта со всеми ссылками, которые нужно скопировать в текстовый документ.

Далее:

В Google Вебмастер: (переход по ссылкам) “Заблокированные URL” -> “Укажите URL-адреса и роботов User Agent для проверки”.

В Яндекс Вебмастер: (переход по ссылкам) “Проверить robots.txt”-> “Список URL”

нужно добавить приготовленный список и нажать кнопку “Проверить”

И вы получите результат проведенной работы.

Кстати, если вы хотите просмотреть свой файл robots.txt, то достаточно дописать в командной строке браузера к url слово: robots.txt

например: http://usersite/robots.txt.

По данной теме читайте следующие статьи:

Что такое redirect-301

Дубли страниц Joomla 2.5

robots.txt Удаление дублей в Joomla 2.5

robots.txt Ошибки и рекомендации

Источники дублей Joomla

+7 (928) 440 - 59 - 70

+7 (928) 440 - 59 - 70 oplgos49@mail.ru

oplgos49@mail.ru